LM Studio是一款可以本地部署的AI模型语言交互软件,在LM Studio软件中,它让用户能够在自己的电脑上轻松运行和体验各种大型语言模型,你可以直接与这些模型进行对话,无需依赖云端服务哦,同时模型管理功能也方便用户查看和管理已下载的模型,一起来下载LM Studio吧!

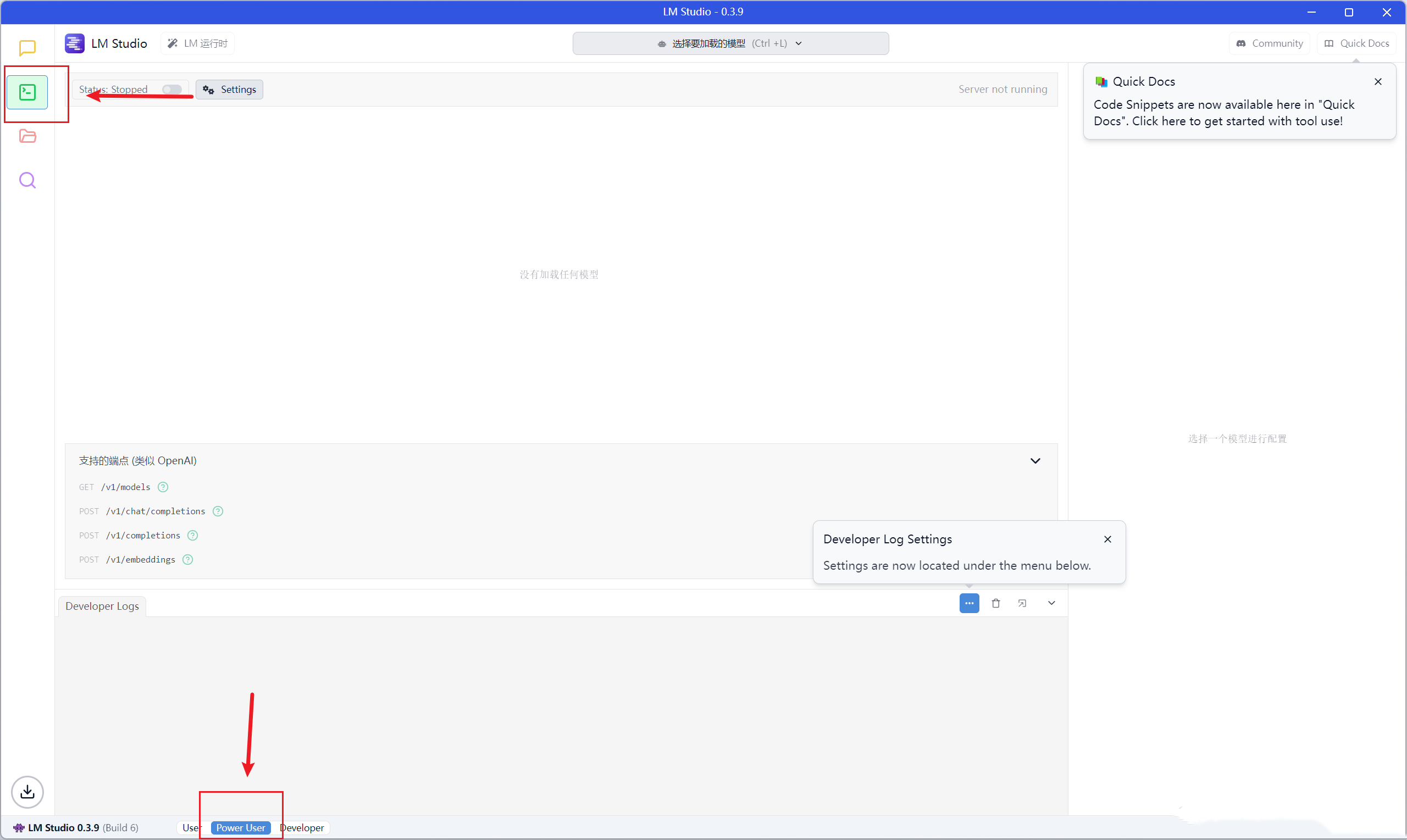

打开左下角【Power User】

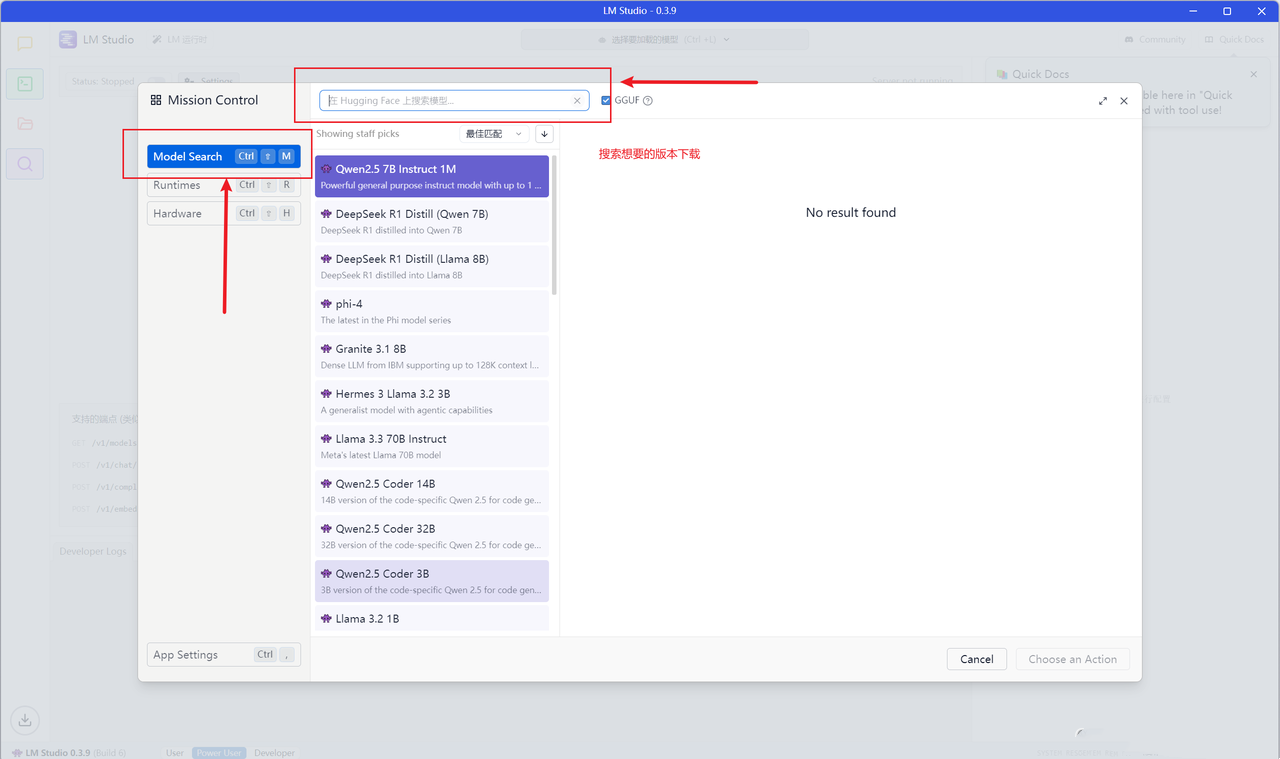

按键【shift+ctrl+R】打开Mission Control

在搜索中找到你需要的模型,进行下载

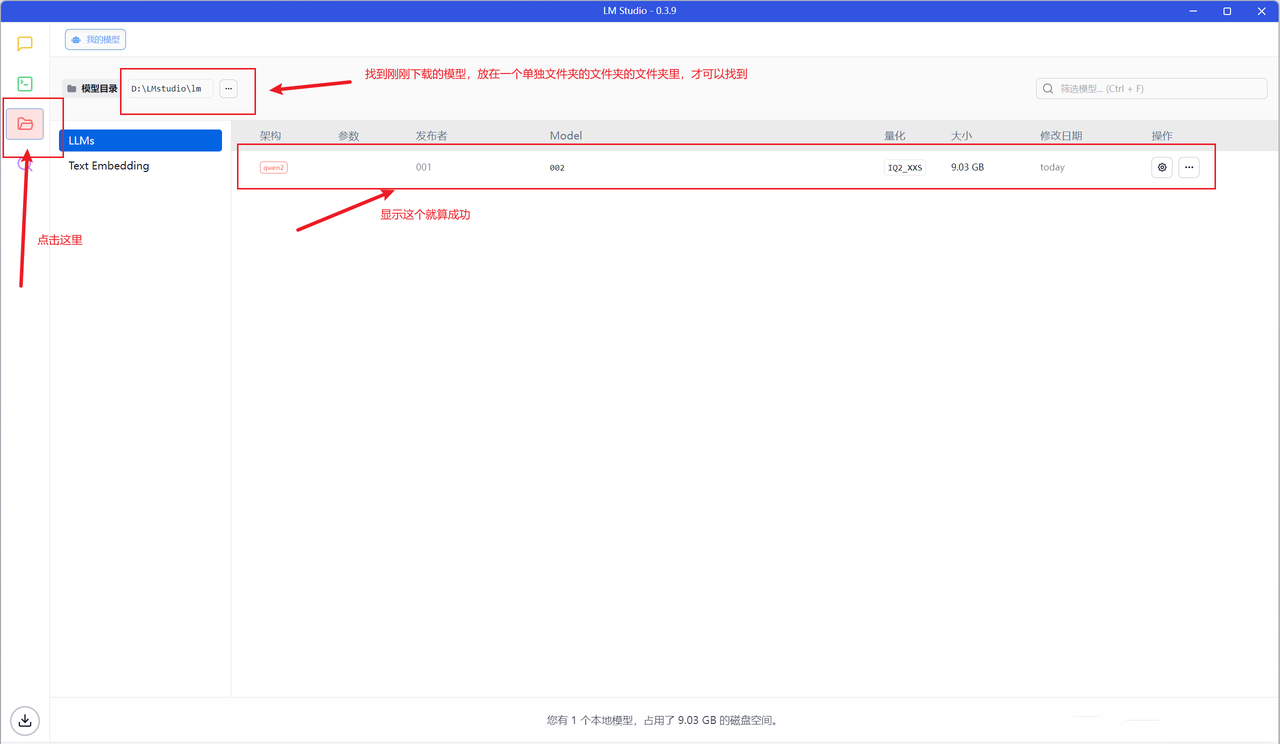

安装后,返回【我的模型】,找到刚刚下载的模型

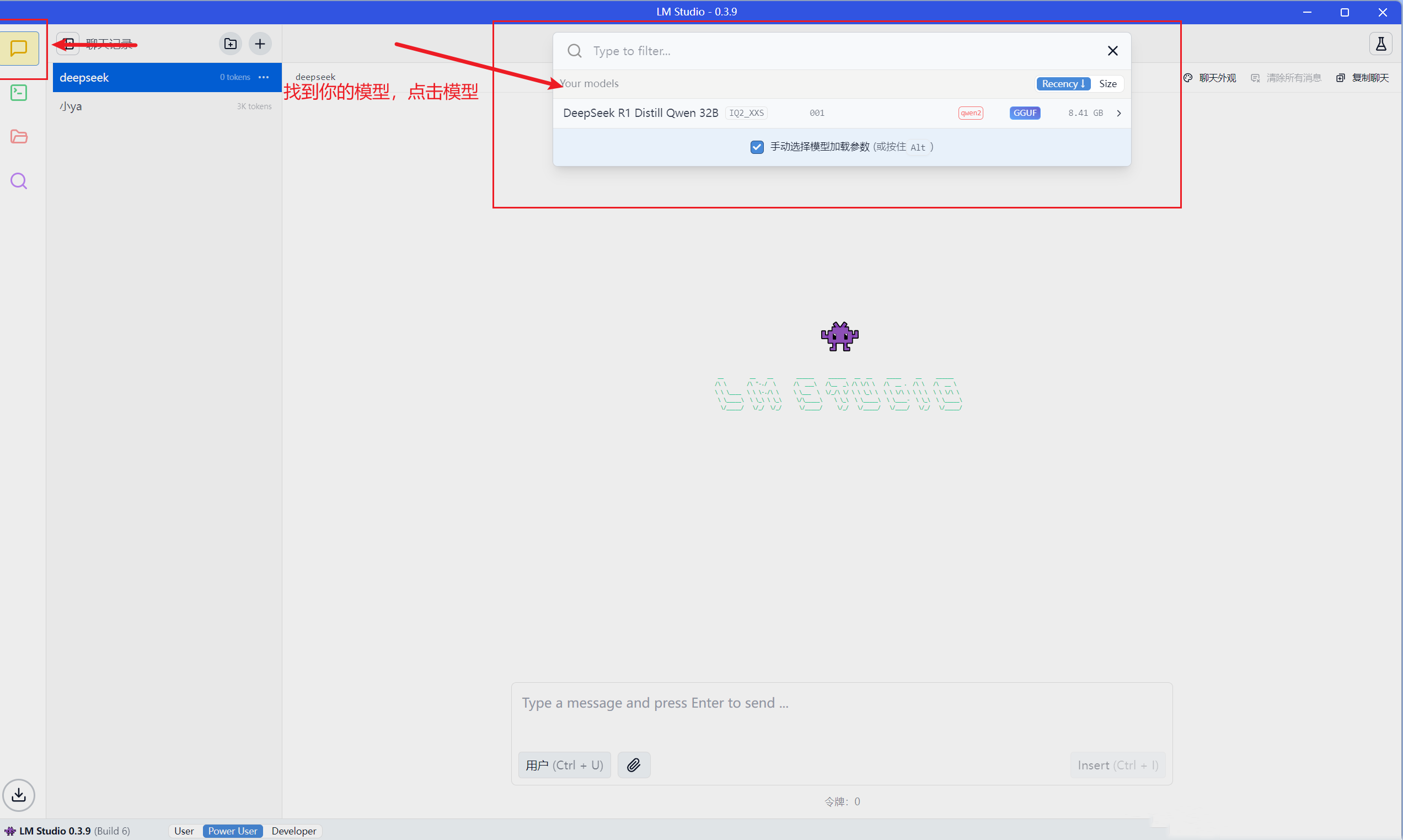

在聊天中,最上方的搜索会显示模型,点击即可使用

模型管理:支持从Hugging Face等资源库中拉取、存储、运行各类GGUF格式模型,用户可以在软件内方便地浏览、搜索和选择自己需要的模型。

硬件协同优化:依托llama.cpp底层架构,针对NVIDIA系列GPU运用GPU卸载技术,合理分配运算任务,突破显存局限;在内存管理方面,借助模型量化手段降低内存占用量,确保设备内存有限的情况下也能平稳加载运行大型模型。

参数调控:用户可灵活调整“温度”“重复惩罚”等参数,精准定制模型输出。比如“温度”参数可调整输出文本的灵活度,“重复惩罚”参数可把控文本多样性。

文本嵌入强化检索:借助POST/v1/embeddings端点生成文本嵌入向量,融入检索增强生成(RAG)架构体系,在海量文档、知识库搜索场景表现卓越。

内置兼容OpenAI的本地服务器功能:无缝衔接既有基于OpenAI API搭建的应用与本地模型,极大缩短开发适配周期,助力创新应用高效落地。

1、模型的多样性与灵活性

借助 LM Studio,你可以轻松获取和管理当今最受欢迎的各种大型语言模型,包括:

Llama 3 :Meta 出品,拥有更强的性能与可靠性,是对话生成任务的绝佳选择。

Phi 3 :Phi 根据大量自然语言和编程数据训练而成,致力于适用于多样化的语言生成任务。

Falcon :以高性能和快速响应为亮点,适合需要快速生成的应用场景。

Mistral :强大的多任务型语言模型,支持多种语言理解与生成任务。

StarCoder :特别设计用于编程任务的模型,代码生成、补全的得力助手。

Gemma :适用于翻译、对话生成等用途的通用型大型语言模型。

这些模型能够满足多样需求,为 AI 应用开发提供了坚实的基础支持。

除此之外,用户可以下载、安装并运行各种基于 Hugging Face 的模型,无需编写代码即可在本地测试模型性能。

无论你的项目需求变化多大,LM Studio 都能提供给你最广泛的模型选择。

2、高效、快速、安全的离线运行

LM Studio 最大的亮点之一在于其针对本地运行的优化。

是的,你无需依赖云端即可体验高效的模型生成。无论是生产环境还是开发测试场景,这为对隐私、安全和速度有高要求的组织和开发者带来了莫大的便捷。

3、简洁友好的用户界面

运行 LLM 模型可不只针对技术人员。LM Studio 通过直观的图形用户界面 (GUI),让用户可以一目了然地下载和管理模型。

下载模型文件仅需点击几下,你甚至可以在应用内创建定制化提示,以更好地与模型互动,降低了上手难度。

几乎不需要任何技术背景,你便能够上手下载、配置并运行你心仪的模型。

4、多样的硬件加速支持

LM Studio 的设计充分考虑了模型性能,它综合利用 GPU 和 CPU 的能力,确保模型在本地以最优效率运行。其多线程优化、硬件加速等多项优化措施,使模型在本地设备上也能够快速响应。

得益于对硬件加速的全面支持,无论是 NVIDIA GPU、Apple MPS,让高效运行成为你指尖的现实。

5、模型自动化管理

对于模型的更新和管理,LM Studio 同样提供了自动化功能。模型的下载、更新和相关环境配置全都可以由应用自动完成,让你无需为模型维护烦心,集中精力专注于开发。

6、优雅的多模型切换

不再担心在多个模型之间切换时的混乱。LM Studio 的界面使你可以轻松切换不同模型,并查看每个模型的详细信息和参数。这意味着,你可以方便地根据需求选择最适合的模型,而无需在文件夹里费力地查找。

7、持续更新

LM Studio 团队致力于保持其技术的领先地位。新模型的支持、新功能的迭代以及性能的优化等方面,团队都在不断努力,因此用户可以享受到最新和最强大的 LLM 技术。